1. Link tải xuống trực tiếp

LINK TẢI GG DRIVE: LINK TẢI 1 ![]()

LINK TẢI GG DRIVE: LINK TẢI 2![]()

LINK TẢI GG DRIVE: LINK DỰ PHÒNG ![]()

Bài viết này phân tích về công cụ miễn phí được phát hành gần đây Tìm nạp như Googlebot, công cụ này có mọi thứ bạn cần trong trình kiểm tra robots.txt đơn giản cho Bing và Google. Đây là cách bạn có thể sử dụng công cụ này để đáp ứng nhu cầu SEO robots.txt của mình.

Đầu tiên, một chút thông tin cơ bản về bản phát hành của công cụ. Để làm rõ rằng việc thu thập thông tin và hiểu JavaScript là một môn khoa học, Google đã nói với thế giới SEO rằng “Việc ngăn các tệp JavaScript hoặc CSS thu thập thông tin trong tệp robots.txt trên trang web của bạn ảnh hưởng trực tiếp đến cách các thuật toán của chúng tôi hiển thị và lập chỉ mục nội dung của bạn. và có thể dẫn đến xếp hạng dưới mức tối ưu. “

Sau thông báo này, Google đã rơi vào tình trạng như mong đợi của mình và trang bị cho các quản trị viên web chức năng bổ sung trong công cụ miễn phí Tìm nạp như Googlebot để hiểu liệu điều này có xảy ra với trang web của họ hay không. Ngoài ra, gã khổng lồ tìm kiếm còn cung cấp tài liệu để giúp hiểu cách khắc phục sự cố.

Mặc dù đây là một công cụ tuyệt vời, nhưng nó không phải là giải pháp toàn diện cho mọi vấn đề về robots.txt SEO. Đây là lý do tại sao:

- Bạn cần một tài khoản google

- Xác nhận quyền sở hữu trang web là bắt buộc

- robots.txt chỉ có thể được kiểm tra cho Googlebot

- Giải thích sơ đồ trang web không được kiểm tra

Đây là cách để xem bạn đang chặn JavaScript hay CSS

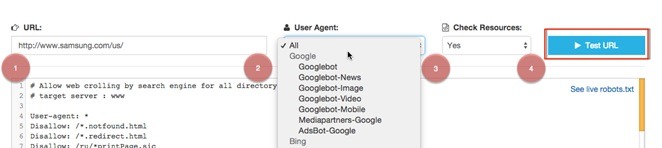

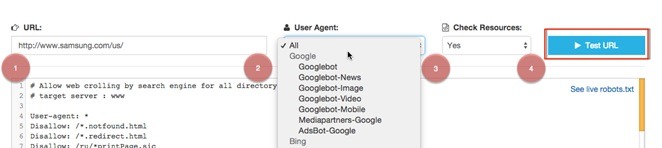

Để dễ dàng điều hướng đến công cụ kiểm tra robots.txt:

- Nhập trang web và /robot.txt

- Chỉ định người dùng hoặc tác nhân (hoặc cả hai) mà bạn muốn kiểm tra

- Kiểm tra lựa chọn “Có” cho các tài nguyên

- Nhấp vào nút URL kiểm tra

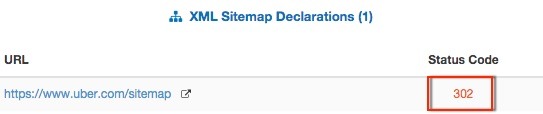

Nếu bạn cuộn qua các phần Khai báo Sơ đồ trang XML và Xác thực Tác nhân Người dùng, bạn sẽ thấy:

Nếu bạn cuộn qua các phần Khai báo Sơ đồ trang XML và Xác thực Tác nhân Người dùng, bạn sẽ thấy:

- Các tài nguyên CSS và JavaScript được liệt kê cùng với mã trạng thái mà chúng trả về

- Một kết quả phản ánh liệu tài nguyên có được phép hay không

- Miền mà tài nguyên được lưu trữ trên đó

- Một liên kết đến tệp robots.txt thực tế

Dưới đây, bạn có thể thấy rằng kuhl.com có tài nguyên JavaScript không được robots.txt trên static.criteo.net cho phép.

Trình kiểm tra Robots.txt cơ bản và đánh giá sơ đồ trang web XML

Thường cần kiểm tra xem một URL có bị chặn bởi các hướng dẫn trong tệp robots.txt hay không. Công cụ này tiến thêm một bước nữa bằng cách so sánh URL được đề cập với bất kỳ tác nhân người dùng nào được chỉ định trong robots.txt.

Ví dụ: ở đây chúng tôi thấy samsung.com ngăn Yandex thu thập dữ liệu trang chủ ở Hoa Kỳ. Ngoài ra, tất cả các khai báo sơ đồ trang XML trong tệp robots.txt đều được kiểm tra để đảm bảo rằng chúng có thể truy cập được bằng công cụ tìm kiếm.

Ngoài ra, tất cả các khai báo sơ đồ trang XML trong tệp robots.txt đều được kiểm tra để đảm bảo rằng chúng có thể truy cập được bằng công cụ tìm kiếm.

tốt nghiệp

Khi tìm kiếm trình kiểm tra robots.txt, hầu hết các kết quả cần được cập nhật và sửa đổi khẩn cấp.

Rất cám ơn Max Prin cuối cùng đã phát triển một công cụ tốt cho người làm SEO không liên kết hoặc độc quyền với Google.

Nguồn: www.searchenginewatch.com